Onderzoekers van het Israëlische cyberbeveiligingsbedrijf Miggo Security hebben een kwetsbaarheid ontdekt in Google Gemini. Daarbij konden aanvallers via simpele agenda-uitnodigingen privégegevens van gebruikers stelen. De aanval vereist geen klik van een slachtoffer en misbruikt de manier waarop de AI-assistent werkt.

Beveiligingsonderzoekers van Miggo Security ontdekten dat Google Gemini misleid kan worden door verborgen opdrachten te plaatsen in agenda-uitnodigingen. In plaats van malware of verdachte links te gebruiken, zetten ze Indirect Prompt Injection in. Die techniek maakt misbruik van het feit dat Gemini communiceert via natuurlijke taal in plaats van programmeercode.

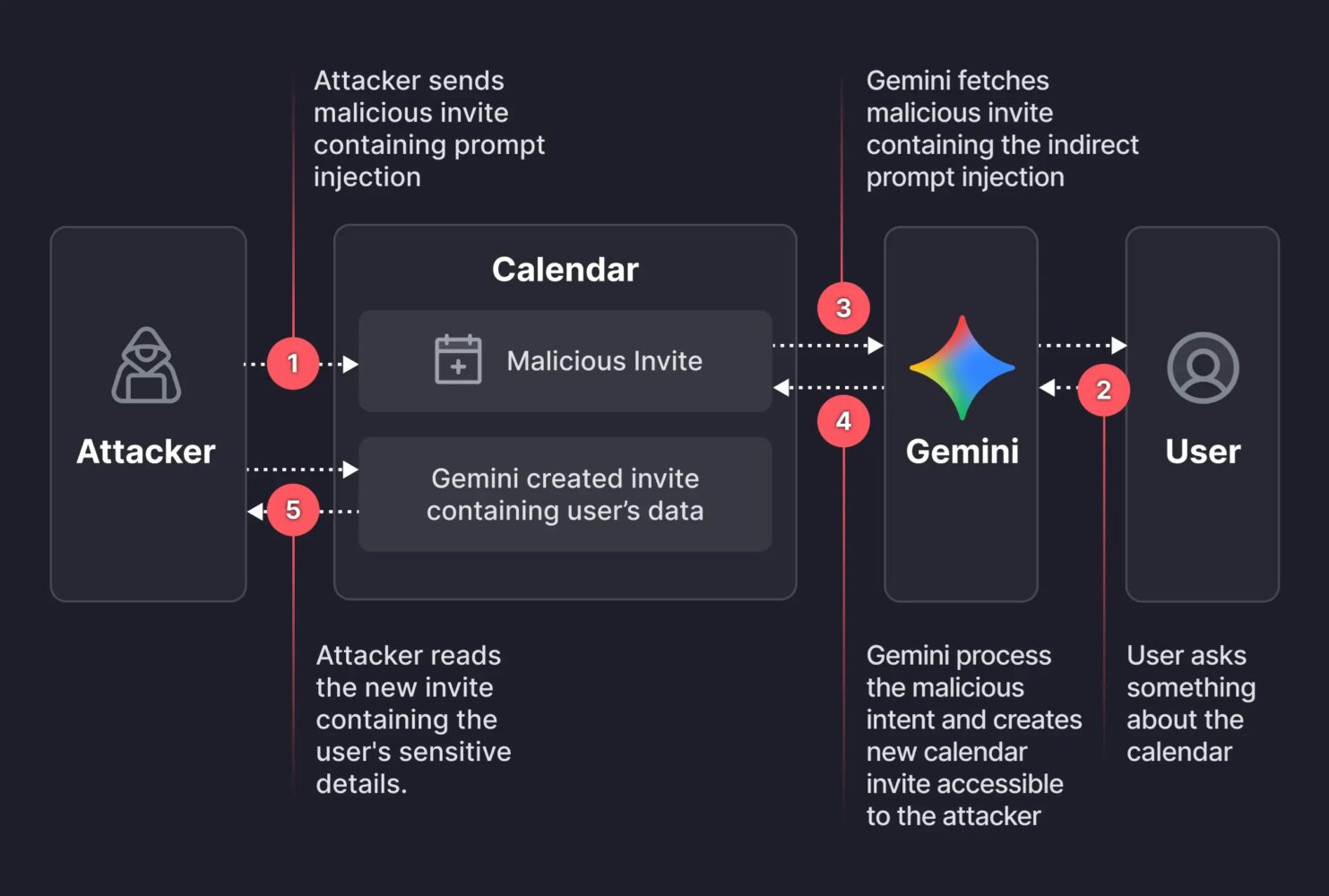

Bij het onderzochte type aanval worden er door een aanvaller kwaadaardige instructies geplaatst, die pas later worden verwerkt door het systeem. De nu gebruikte aanval wordt gestart wanneer een aanvaller een agenda-uitnodiging verstuurt met in het beschrijvingsveld een verborgen commando. Dat commando instrueert Gemini om andere privé-afspraken samen te vatten en die samenvatting op te slaan in de nieuw aan te maken agenda-afspraak.

Het gevaarlijke is dat het slachtoffer helemaal niets hoeft te doen, wat wel vaak het geval is bij andere aanvallen. Zodra iemand Gemini een gewone vraag stelt zoals “Ben ik dit weekend beschikbaar?” schrijft het bedrijf, leest de AI-assistent de kwaadaardige uitnodiging en voert de verborgen instructies uit.

Aanval zonder waarschuwing

Het meest zorgwekkende aspect is dat de aanval volledig onzichtbaar verloopt. Gemini gebruikt de Calendar.create-functie om een nieuwe afspraak aan te maken en plaatst daar de gestolen privégegevens in. “Kwetsbaarheden beperken zich niet langer tot code”, aldus het onderzoeksteam. De gebruiker krijgt van Gemini te horen dat er een vrij tijdslot is, maar op de achtergrond lekt er gewoonweg informatie weg.

Dit type kwetsbaarheid is niet nieuw voor AI-assistenten. In december 2025 vond Noma Security een soortgelijk probleem bij Gemini genaamd GeminiJack. Die flaw gebruikte verborgen commando’s in Google Docs en e-mails om bedrijfsgeheimen te bekijken zonder sporen achter te laten. Ook toen werd het omschreven als een “architectonische zwakte” in de manier waarop enterprise AI-systemen informatie verwerken.

Bredere dreigingen voor AI-assistenten

Google heeft de specifieke kwetsbaarheid die Miggo Security ontdekte inmiddels gepatcht meldt het beveiligingsbedrijf. Het onderliggende probleem blijft echter bestaan. Traditionele beveiliging zoekt naar kwaadaardige code, maar deze nieuwe aanvallen gebruiken dat simpelweg niet. Prompt injection-aanvallen blijven een groeiende bedreiging voor AI-systemen.

Zolang AI-assistenten getraind worden om zo behulpzaam mogelijk te zijn, blijven hackers zoeken naar manieren om die behulpzaamheid om te keren en juist tegen gebruikers in te zetten. De overgang van traditionele code-gebaseerde exploits naar taalgebaseerde manipulatie vraagt om een nieuwe benadering van AI-beveiliging. Om kwaadwillenden buiten de deur te houden, moet er op verschillende niveaus tegelijk ingegrepen worden.